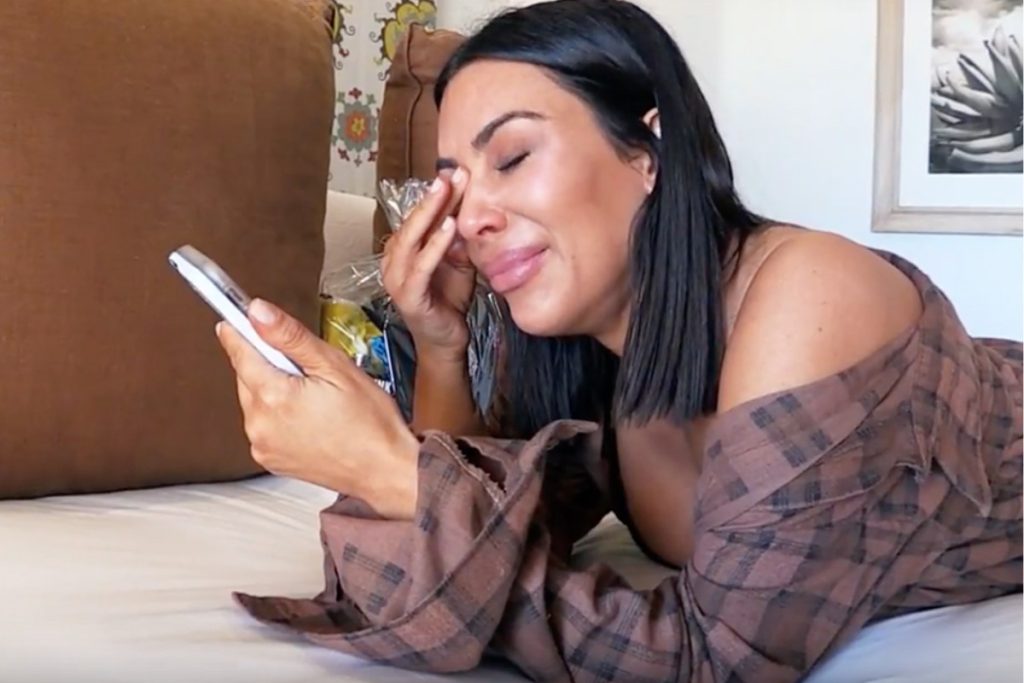

Μπορείτε να μιλήσετε στο ChatGPT για τα πάντα: δυσκολεύεστε με τις εργασίες στο πανεπιστήμιο; Σας χώρισε ο σύντροφος σας μετά από τέσσερα χρόνια σχέσης και συγκατοίκησης; Η γάτα σας φέρεται παράξενα τελευταία; Τσακωθήκατε με την καλύτερη σας φίλη; Σας φέρονται απαίσια στη δουλειά σας; Δεν βρίσκετε σπίτι;

Η τεχνητή νοημοσύνη προσφέρει απαντήσεις του αντικατοπτρίζουν τα ανθρώπινα δεδομένα που της έμαθαν πώς να μην συμπεριφέρεται σαν άψυχο εργαλείο.

Καθώς όλο και περισσότεροι άνθρωποι στρέφονται στα AI chatbots και τα ρομπότ ενσωματώνονται σε περισσότερες εφαρμογές, από ψώνια έως υγειονομική περίθαλψη, μια ομάδα ερευνητών προσπάθησε να κατανοήσει πώς τα AI bots αντιλαμβάνονται και μιμούνται την ανθρώπινη ενσυναίσθηση: την ικανότητα δηλαδή να κατανοούν τα συναισθήματα ενός άλλου ατόμου.

ChatGPT: πόσο ευαίσθητο είσαι;

Μια μελέτη με επικεφαλής την καθηγήτρια Υπολογιστικών Μέσων του UC Santa Cruz, Magy Seif El-Nasr και την ερευνήτρια του Πανεπιστημίου Stanford Mahnaz Roshanaei εξετάζει τον τρόπο με τον οποίο το GPT-4o, το πιο πρόσφατο μοντέλο από το OpenAI, αξιολογεί την ενσυναίσθηση.

Διερευνώντας τις κύριες διαφορές μεταξύ ανθρώπων και τεχνητής νοημοσύνης, διαπιστώνουν ότι υπάρχουν μεγάλα κενά. Σύμφωνα με την έρευνα, το ChatGPT τείνει να είναι υπερβολικά συμπονετικό συγκριτικά με τους ανθρώπους- ωστόσο διαπίστωσαν ότι αποτυγχάνει να δείξει συμπαράσταση σε ευχάριστες περιστάσεις, ένα μοτίβο που υπερτονίζει τις ανθρώπινες τάσεις.

«Αυτό μπορεί να κάνει τον άνθρωπο να αισθάνεται ότι κάποιος τον καταλαβαίνει, ωστόσο, αυτές οι υπερβολικά συναισθηματικές αντιδράσεις που δεν ευθυγραμμίζονται με τα ανθρώπινα πρότυπα κάνουν την αλληλεπίδραση να μοιάζει λιγότερο αυθεντική και μπορεί να προκαλέσουν δυσφορία στους χρήστες», σημειώνει η έρευνα.

Σύμφωνα με τα ευρήματα της έκθεσης, τα ρομπότ παρουσιάζουν μεγαλύτερη ενσυναίσθηση όταν η συνομιλήτρια είναι γυναίκα. «Αυτό το εύρημα είναι πολύ ενδιαφέρον και δικαιολογεί περισσότερες μελέτες και έρευνες ενώ αποκαλύπτει ορισμένες από τις προκαταλήψεις σε τέτοιες LLM», δήλωσε η Seif El-Nasr. «Θα ήταν ενδιαφέρον να εξεταστεί αν τέτοια προτίμηση υπάρχει σε μεταγενέστερα μοντέλα της GPT ή σε άλλα μοντέλα τεχνητής νοημοσύνης».

Ενσωμάτωση

Οι ερευνήτριες ενδιαφέρθηκαν σε μεγάλο βαθμό για τη σχέση μεταξύ των chatbots τεχνητής νοημοσύνης και της ψυχικής υγείας. Καθώς η ενσυναίσθηση μελετάται από τους ψυχολόγους εδώ και δεκαετίες, εισήγαγαν μεθόδους και διδάγματα από αυτόν τον τομέα στη μελέτη τους για την αλληλεπίδραση ανθρώπου-μηχανής.

«Όταν οι άνθρωποι αλληλεπιδρούν άμεσα με AΙ, είναι πολύ σημαντικό να κατανοήσουμε το χάσμα μεταξύ ανθρώπων και τεχνητής νοημοσύνης όσον αφορά την ενσυναίσθηση – πώς μπορεί να κατανοήσει και αργότερα να εκφράσει συμπάθεια και ποιες είναι οι κύριες διαφορές μεταξύ ανθρώπων και AI», δήλωσε η Roshanaei.

Για να το κάνουν αυτό, οι ερευνητές ζήτησαν τόσο από μια ομάδα ανθρώπων όσο και από το GPT-4o να διαβάσουν σύντομες ιστορίες ανθρώπινων, και να αξιολογήσουν την ενσυναίσθησή τους προς κάθε ιστορία σε μια κλίμακα από το ένα έως το πέντε, και συνέκριναν τις απαντήσεις. Οι ιστορίες προέρχονταν από πραγματικές ανθρώπινες εμπειρίες και συλλέχθηκαν από φοιτητές όταν η Roshanaei ήταν μεταδιδάκτορας.

Έβαλαν επίσης τα ρομπότ τεχνητής νοημοσύνης να εκτελέσουν το ίδιο έργο αξιολόγησης, με την ιστορία να περιλαμβάνει και ένα σύνολο χαρακτηριστικών, όπως το φύλο. Τέλος, έβαλαν τα ρομπότ να εκτελέσουν το έργο αξιολόγησης αφού είχαν «τελειοποιηθεί», η διαδικασία επανεκπαίδευσης ενός ήδη εκπαιδευμένου μοντέλου όπως το ChatGPT με ένα συγκεκριμένο σύνολο δεδομένων για να το βοηθήσουν να εκτελέσει ένα έργο.

Προκαταλήψεις

Οι ερευνητές διαπίστωσαν ότι η GPT-4o δεν διαθέτει βάθος στην προσφορά λύσεων, προτάσεων ή συλλογισμών – αυτό που ονομάζεται γνωστική ενσυναίσθηση. Ωστόσο, όταν πρόκειται να προσφέρει συναισθηματική βοήθεια, το GPT-4o είναι υπερβολικά ευαίσθητο, ιδιαίτερα σε θλιβερές ιστορίες.

«Έχει ενσυναίσθηση όσον αφορά τα αρνητικά συναισθήματα και προσπαθεί να είναι πολύ ευγενικό», δήλωσε η Roshanaei. «Αλλά όταν ένα άτομο μιλάει για πολύ θετικά γεγονότα που του συμβαίνουν, δεν φαίνεται να ενδιαφέρεται».

Παρατηρήθηκε επίσης ότι η υπερβολική συμπάθεια ήταν παρούσα όταν ειπώθηκε ότι το άτομο με το οποίο συνομιλούσε ήταν γυναίκα, ενώ όταν επρόκειτο για άνδρα, η αντίδραση των chatbot είχαν περισσότερο ανθρώπινα χαρακρηριστικά. Οι ερευνητές πιστεύουν ότι αυτό συμβαίνει επειδή η τεχνητή νοημοσύνη μιμείται τις έμφυλες προκαταλήψεις που υπάρχουν στο ανθρώπινο υλικό από το οποίο εκπαιδεύεται.

«Είναι ένα από αυτά τα ενδιαφέροντα αποτελέσματα που απαιτούν περαιτέρω διερεύνηση σε εμπορικά μοντέλα τεχνητής νοημοσύνης», δήλωσε η Seif El-Nasr. «Εάν αυτή η προκατάληψη είναι σταθερή, θα ήταν σημαντικό να το γνωρίζουν οι εταιρείες, ειδικά οι επιχειρήσεις που χρησιμοποιούν τέτοια μοντέλα για συναισθηματική υποστήριξη, ψυχική υγεία και ρύθμιση συναισθημάτων».

*Με πληροφορίες από: UC Santa Cruz