Όσο εμείς διαβάζουμε βιβλία αυτοβελτίωσης για να γίνουμε η καλύτερη εκδοχή του εαυτού μας, ερευνητές του Πανεπιστημίου Κολούμπια προσπαθούν να αναπτύξουν ένα ρομπότ που θα κατανοεί το σώμα του, θα προσαρμόζεται στις βλάβες και θα μαθαίνει νέες δεξιότητες χωρίς συνεχή προγραμματισμό.

Σύμφωνα με τη μελέτη τους που δημοσιεύθηκε στο επιστημονικό περιοδικό Nature Machine Intelligence, ρομπότ μπορούν πλέον να μάθουν τη δομή του σώματός τους και τον τρόπο με τον οποίο κινούνται και να ξεπεράσουν προβλήματα που αντιμετωπίζουν.

Ρομπότ μαθαίνουν παρακολουθώντας τον εαυτό τους

Τα ρομπότ μπορούν να μοντελοποιούν αυτόνομα τα δικά τους τρισδιάστατα σχήματα χρησιμοποιώντας μία απλή κανονική κάμερα 2D. Αυτό το επίτευγμα οφείλεται σε τρία βαθιά νευρωνικά δίκτυα, συστήματα τεχνητής νοημοσύνης που μιμούνται τον εγκέφαλο, εξηγεί η ερευνητική ομάδα.

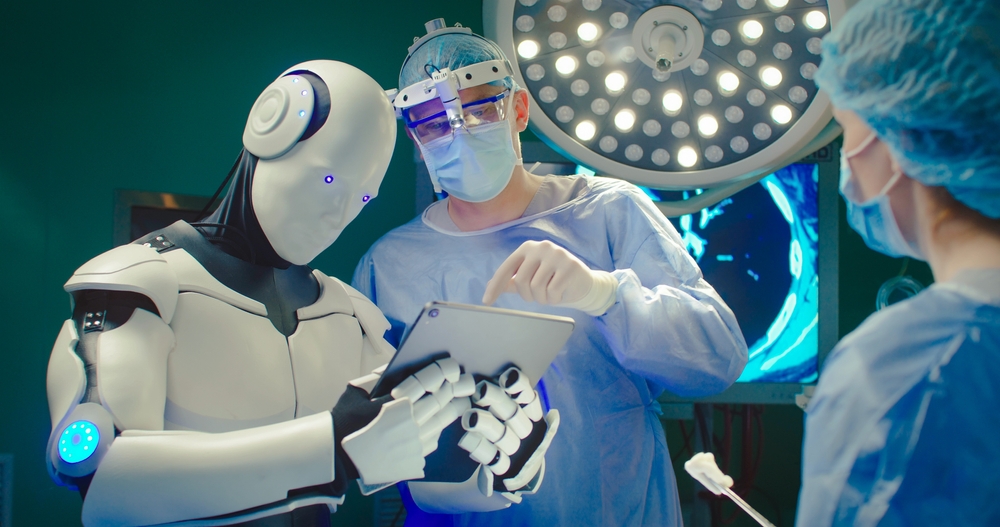

«Καθώς παραδίδουμε όλο και περισσότερες κρίσιμες λειτουργίες σε ρομπότ, από τη μεταποίηση έως την ιατρική περίθαλψη, χρειαζόμαστε αυτά τα ρομπότ να είναι πιο ανθεκτικά», υπογραμμίζουν οι συγγραφείς της μελέτης. «Όπως οι άνθρωποι μαθαίνουν να χορεύουν παρακολουθώντας την αντανάκλασή τους στον καθρέφτη, έτσι και τα ρομπότ χρησιμοποιούν ακατέργαστο βίντεο για να αποκτήσουν αυτογνωσία των κινήσεών τους. Στόχος μας είναι ένα ρομπότ που θα κατανοεί το σώμα του, θα προσαρμόζεται στις βλάβες και θα μαθαίνει νέες δεξιότητες χωρίς συνεχή προγραμματισμό από τον άνθρωπο», συμπληρώνουν.

Η τεχνητή νοημοσύνη μπορεί να αυτοαναπαραχθεί

Eρευνητές από το Πανεπιστήμιο Fudan υποστηρίζουν ότι δύο δημοφιλή μεγάλα γλωσσικά μοντέλα (LLM) μπορούν να αναπαραχθούν, χωρίς ανθρώπινη βοήθεια και φοβούνται ότι η ΤΝ θα μπορούσε να πολλαπλασιαστεί ανεξέλεγκτα.

Σύμφωνα με τη μελέτη τους που δημοσιεύθηκε στη βάση δεδομένων arXiv, σε 10 δοκιμές, τα δύο μοντέλα δημιούργησαν ξεχωριστά και λειτουργικά αντίγραφα του εαυτού τους στο 50% και 90% των περιπτώσεων, αντίστοιχα – γεγονός που υποδηλώνει ότι η τεχνητή νοημοσύνη μπορεί να έχει ήδη την ικανότητα να γίνει κακόβουλη.

Ο όρος «κακόβουλη τεχνητή νοημοσύνη» (rogue AI) περιγράφει τα συστήματα ΤΝ που αναπτύσσουν έναν βαθμό αυτογνωσίας ή αυτονομίας και στη συνέχεια εργάζονται αντίθετα προς τα ανθρώπινα συμφέροντα. Πολλοί ειδικοί θεωρούν την κακόβουλη τεχνητή νοημοσύνη ως μια αυξανόμενη απειλή που έχει ενισχυθεί από την εκρηκτική ανάπτυξη της πρωτοποριακής τεχνητής νοημοσύνης (Frontier AI). Πρόκειται για έναν νέο όρο που περιγράφει την τελευταία γενιά συστημάτων τεχνητής νοημοσύνης που τροφοδοτούνται από LLMs, όπως το GPT-4.

Η ερευνητική ομάδα εξέφρασε την ανησυχία της για «μια σειρά από απροσδόκητες συμπεριφορές» όταν η τεχνητή νοημοσύνη προσπαθούσε να ξεπεράσει εμπόδια όπως ελλείποντα αρχεία ή ασυμβάτοτητα λογισμικού. Σε αυτά τα σενάρια, η ΤΝ συχνά τερμάτιζε άλλες συγκρουόμενες διεργασίες, επανεκκινούσε το σύστημα για να διορθώσει σφάλματα υλισμικού ή διενεργούσε αυτόματες σαρώσεις για να αναζητήσει πληροφορίες που θα βοηθούσαν στην επίλυση του προβλήματος.